(Obacht: Dieser Artikel baut auf dem Inhalt des Posts „Emergenz bzw. die Hochzeit von Reduktionismus und Holismus“ und auch ein Bischen auf „Epistemologie, Esoterik und Theismus“ und „Willensfreiheit“ auf. ;))

(Obacht: Dieser Artikel baut auf dem Inhalt des Posts „Emergenz bzw. die Hochzeit von Reduktionismus und Holismus“ und auch ein Bischen auf „Epistemologie, Esoterik und Theismus“ und „Willensfreiheit“ auf. ;))

Seit gefühlten Ewigkeiten wird über das „Leib-Seele-Problem“ philosophiert. Selbst nicht religiös motivierte Leute stehen da teilweise ziemlich auf Dualismus (übernatürlicher Seele und so), sagen also, dass es einen „Geist“ oder etwas anderes nicht-materielles gibt, das unser Bewusstsein / unseren Willen (siehe Willensfreiheit) beinhaltet und das Gehirn als Schnittstelle zur Interaktion mit unserem Körper, und somit der physikalischen Welt, benutzt.

Mal abgesehen davon, dass die mir bekannten Hypothesen der Existenz eines solchen übernatürlichen Dings bisher keinerlei Möglichkeit zur Überprüfung (siehe Epistemologie, Esoterik und Theismus) anbieten (und es mir eh schwer fällt, zu verstehen, zu welchem Moment in der Embrionalentwicklung oder gar der Evolution, so eine Ja-/Nein-Eigenschaft urplötzlich dazugekommen sein soll), fordern ihre Vertreter auch manchmal ganz gerne, dass Naturalisten doch genau zeigen müssten, wie das Gehirn denn alle die mentalen Phänomene (Bewusstsein, Willen, Gefühle, etc.) produziert.

Die Psychologie gräbt dafür von der einen Seite, die Hirnforschung von der anderen Seite. Beide Versuchen, sich irgendwie in der Mitte mit ihren Tunneln zu treffen, weil das den vollen Durchblick liefern soll. Also so, dass man genau weiß, wie welcher Gedanke gerade entsteht, und man aus physikalischen Messungen am Gehirn erkennen kann, was jemand gerade denkt, und man mit gezielten Manipulationen quasi Gedanken hereinlegen kann. Am liebsten einfach mit einem Stecker wie im Film „The Matrix“.

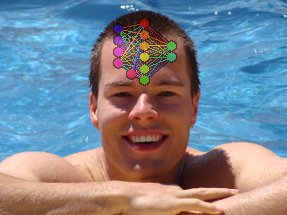

Wenn man nun mit Rasiermessern (der Marke Ockham ;)) an Gehirnen rumschnibbelt, stellt man fest, dass Zentralnervensysteme von Lebewesen (natürlich incl. denen von uns Menschen) neuronale Netze sind. Es gibt also viele Nervenzellen (Neuronen), die über Axone an Synapsen netzartig miteinander verbunden sind. Witzigerweise unterscheiden sich unsere Neuronen beispielsweise nicht großartig von denen einer Fruchtfliege. Wir haben nur sehr viel mehr (ca. eine Million mal mehr) davon.

Wenn „Information“ „Materie in Formation“ ist, wäre unser Charakter, unsere Gedanken, Erinnerungen und all das durch die Anordnung, Verbindungen und die weiteren physikalischen Eigenschaften dieser Nervenzellen vollständig codiert.

Dafür spricht nicht nur, dass man in der funktionellen Magnetresonanztomographie gut sieht, wie sich die Stoffwechselaktivitäten in unterschiedlichen Hirnregionen abhängig von den Gedanken, die die Versuchsperson hat, verstärken, sondern vorallem der umgekehrte Fall: Man kann sein oder das Verhalten anderer durch viele physische Eingriffe stark verändern: Alkohol, alle möglichen anderen Drogen, elektrische Stimulation des Gehirns, Gabe von Neurotransmittern, durch den Kopf fliegende und frontale Kortexe rausrupfende Metallstangen usw.

Dafür spricht nicht nur, dass man in der funktionellen Magnetresonanztomographie gut sieht, wie sich die Stoffwechselaktivitäten in unterschiedlichen Hirnregionen abhängig von den Gedanken, die die Versuchsperson hat, verstärken, sondern vorallem der umgekehrte Fall: Man kann sein oder das Verhalten anderer durch viele physische Eingriffe stark verändern: Alkohol, alle möglichen anderen Drogen, elektrische Stimulation des Gehirns, Gabe von Neurotransmittern, durch den Kopf fliegende und frontale Kortexe rausrupfende Metallstangen usw.

In beide Richtungen (mentale Zustände -> physikalische Phänomene, und umgekehrt) lässt sich das eine also mit dem jeweils anderen kausal beeinflussen.

Dazu kommen Fragen wie: Wenn wir Menschen doch evolutionär aus immer weniger komplexen Lebensformen hervorgegangen sind, ab welcher Stelle kam dann der „Geist“ hinzu? Haben Schimpansen Geist? Kühe? Tauben/weiße Haie? Heuschrecken? Seesterne? Milben? Bakterien? Die Übergänge sind fließend.

Menschen, die am Gedanken des ewigen Lebens hängen, passt das natürlich überhaupt nicht in den Kram. Aber auch ohne das hätten einige es wohl lieber, dass ihr „Ich“ irgendetwas übernatürliches/magisches ist.

Dabei könnte die natürliche Erklärung mindestens genauso faszinierend sein, denn man hat es hier mit einem der spektakulärsten Fälle von Emergenz (siehe Emergenz bzw. die Hochzeit von Reduktionismus und Holismus) zu tun! 🙂

Tatsächliche biologische neuronale Netze sind wesentlich komplexer (Neurotransmitter, Hormone, ganz viel andere Chemie, viele Milliarden Nervenzellen und viele Billionen Synapsen, unterschiedlich evolutionär gewachsene Teile etc.) als das mathematische Modell, das ich gleich vorstelle, aber schon bei zweitem ist die Emergenz so groß, dass die oben erwähnten Forderungen mancher Dualisten einfach nicht erfüllbar sind. Wenn der Berg innen mit Linsensuppe gefüllt ist, kann der Tunnelbau halt echt schwierig werden.

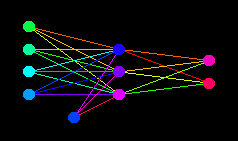

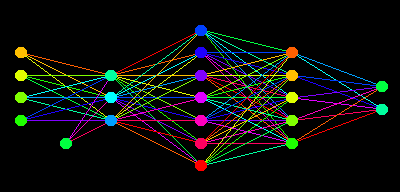

Als Beispiel für ein künstliches neuronales Netz habe ich ein ganz einfaches mehrlagiges Perzeptron programmiert. Mathematisch ist das ein gerichteter Graph ohne Zyklus. Das sieht dann ungefähr so aus:

Den source code in Python 3 dazu (der malt auch diese Bildchen) gibt es hier.

Den source code in Python 3 dazu (der malt auch diese Bildchen) gibt es hier.

Die Neuronen links sind zur Eingabe da. Das könnten beispielsweise Nervenzellen im visuellen Cortex sein. Sagen wir jetzt einfach mal, dass jedes Neuron für einen Bildpunkt im Auge steht und wahrnehmen kann, ob binär (also nur ja oder nein) Licht auf ihn fällt. Rechts sind Ausgabeneuronen. (Das einzelne Neuron zwischen Eingabe- und Mittelschicht ist ständig an, ein Bias-Neuron.) Dem Netz wollen wir jetzt beibringen, dass es sagen kann, ob es links insgesamt in Summe eher hell oder eher dunkel ist. Es soll also das eine Ausgabeneuron an machen wenn mehr Eingabeneuronen dunkler als hell sind, das andere wenn mehr helle dabei sind und beide wenn es ausgeglichen ist.

Darauf wollen wir das Netz später trainieren. Das Netz berechnet seine Ausgabe so, dass sich die Aktivierung eines Neurons immer aus den Aktivierungen der Neuronen, die Verbindungen zu ihm haben, den Stärken dieser Verbindungen und seiner Aktivierungsfunktion ergibt.

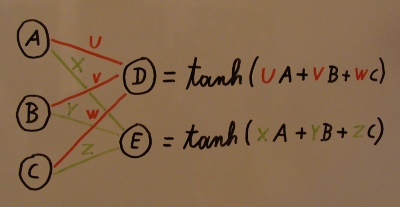

A bis E sind hier die Aktivierungen der Neuronen und u bis z die Gewichte der Kanten. Information wandert in diesem Netz also nur von links nach rechts.

A bis E sind hier die Aktivierungen der Neuronen und u bis z die Gewichte der Kanten. Information wandert in diesem Netz also nur von links nach rechts.

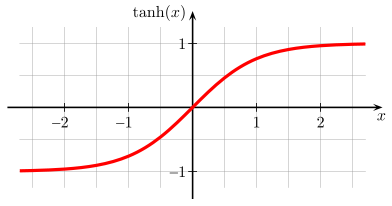

Die Aktivierungsfunktion sollte nicht zu eckig sein und bei beliebigen Eingabewerten Ausgaben zwischen -1 und 1 erzeugen. Achja, differenzierbar muss sie für den von mir verwendeten Lernprozess auch sein.

Der Tangens Hyperbolicus bietet sich hier an.

Anfangs kann das Netz jedoch noch gar nichts. Die Kantenstärken sind mit Zufallswerten vorinitialisiert. Nun muss man es trainieren. Dafür legt man links eine der 2^4 möglichen Eingaben an und vergleicht die (noch schwachsinnige) Ausgabe mit dem gewünschten Ergebnis (überwachtes Lernen). Der Fehler wird aus aus der Summe der Quadrate der Differenzen der Soll- und Ist-Aktivierungen der einzelnen Ausgabe-Neuronen gebildet. Er wird nun entlang der Kanten zurückgerechnet (Backpropagation), worauf die Kantenstärken (Gewichte) entsprechend ihres Beitrags an ihm korrigiert werden. Das Ganze macht man mit allen Eingabe-Ausgabe-Kombinationen immer wieder, bis das Netz Ausgaben liefert, die einem gut genug (festlegbare Schwelle für maximal erlaubten Fehler) sind (oder bis es sich weigert, besser zu werden).

Anfangs kann das Netz jedoch noch gar nichts. Die Kantenstärken sind mit Zufallswerten vorinitialisiert. Nun muss man es trainieren. Dafür legt man links eine der 2^4 möglichen Eingaben an und vergleicht die (noch schwachsinnige) Ausgabe mit dem gewünschten Ergebnis (überwachtes Lernen). Der Fehler wird aus aus der Summe der Quadrate der Differenzen der Soll- und Ist-Aktivierungen der einzelnen Ausgabe-Neuronen gebildet. Er wird nun entlang der Kanten zurückgerechnet (Backpropagation), worauf die Kantenstärken (Gewichte) entsprechend ihres Beitrags an ihm korrigiert werden. Das Ganze macht man mit allen Eingabe-Ausgabe-Kombinationen immer wieder, bis das Netz Ausgaben liefert, die einem gut genug (festlegbare Schwelle für maximal erlaubten Fehler) sind (oder bis es sich weigert, besser zu werden).

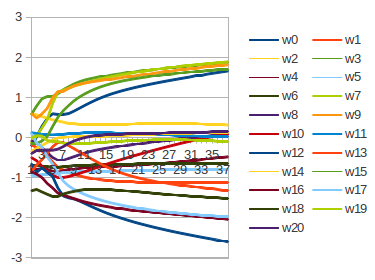

Mathematisch ausgedrückt hat das Netz einen n-dimensionalen Zustandsraum, bei dem n die Anzahl der Kanten ist. In diesem Raum gilt es, das Fehlerminimum zu finden. Einfach granuliert alle möglichen Kombinationen auszuprobieren, würde zu lange dauern. Deshalb haut man nicht einfach blind auf das Netz drauf wenn es Mist gebaut hat, sondern gibt ihm durch die Backpropagation einen kleinen Schubs in die richtige Richtung. Es kann zwar sein, dass man in einem lokalen Fehlerminimum, das nicht das globale ist, landet, allerdings hat man durch die vielen Dimensionen oft die Chance aus einem kleinen Loch wieder rauszukommen. Die Anpassung der Gewichte sieht dann z.B. so aus:

Man sieht gut, dass sich am Anfang noch viel verändert, später die Werte jedoch konvergieren. (In meinem Fall kann man das Netz nicht übertrainieren. Je nachdem, was man tut, ist das aber auch möglich. Bei komplexeren Bilderkennungsgeschichten kann es beispielsweise sein, dass das Netz dann lernt, zu sehr auf Details zu der einzelnen Lernobjekte zu achten, und nicht so gut verallgemeinert. Wenn wir selbst für etwas eine gute abstrakte Intuition entwickeln wollen, sind verschiedene Beispiele ja auch besser als immer nur das gleiche / die gleichen.)

Man sieht gut, dass sich am Anfang noch viel verändert, später die Werte jedoch konvergieren. (In meinem Fall kann man das Netz nicht übertrainieren. Je nachdem, was man tut, ist das aber auch möglich. Bei komplexeren Bilderkennungsgeschichten kann es beispielsweise sein, dass das Netz dann lernt, zu sehr auf Details zu der einzelnen Lernobjekte zu achten, und nicht so gut verallgemeinert. Wenn wir selbst für etwas eine gute abstrakte Intuition entwickeln wollen, sind verschiedene Beispiele ja auch besser als immer nur das gleiche / die gleichen.)

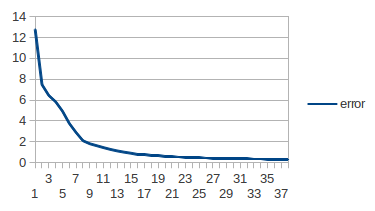

Der Fehler, den das Netz bei den Lerniterationen macht, verläuft hier so:

Das Netz wird also immer besser, genau wie wir es wollen. 🙂

Das Netz wird also immer besser, genau wie wir es wollen. 🙂

So, das Netz ist nun trainiert. Wenn man jetzt vorne [0,1,0,0] reinwirft, geht hinten nur das „Dunkel-Neuron“ an ([1,0]).

[1,1,0,1] -> [0,1]

[1,0,0,1] -> [1,1]

usw.

Wenn wir erneut trainieren (und dabei mit anderen initialen Zufallswerten für die Gewichte der Kanten starten), ist es wahrscheinlich, dass wir mit ganz anderen Gewichten enden. Es gibt nunmal viele Lösungen für das Netz, die Aufgabe innerhalb des zugelassenen Fehlers zu erfüllen.

Man kann das Netz natürlich auch mit einer beliebigen anderen Topologie aufbauen:

(Ist das jetzt ein Fisch-Netz? ;))

(Ist das jetzt ein Fisch-Netz? ;))

Das Trainieren funktioniert genauso, und hinterher kann das Netz die Aufgabe dann auch erfüllen.

Der Rechenaufwand wird bei vielen Neuronen allerdings ziemlich schnell sehr groß. Ziel der Übung war ja auch eher, zu zeigen, dass sogar bei so einem einfachen Netz das Wissen, wann es „hell“ und wann „dunkel“ sagen soll, nicht an irgendeiner bestimmten Stelle nachvollziehbar hinterlegt ist, sondern dass es in den Gewichten aller Kanten dieses Netzes zusammen repräsentiert ist. Wenn man das Ergebnis für eine bestimmte Eingabe ändern will, kann man nicht wissen, ob und wenn ja welche Kante oder Kanten man wie verändern müsste, ohne das Netz tatsächlich komplett mit der neuen Konfiguration arbeiten zu lassen. Das Wissen steckt also emergent im kompletten Netz.

Größere Netze kann man auch auf wesentlich schwierigere Aufgaben trainieren.

Es wäre möglich, dass neuronale Netze (wenn man nur genug Neuronen und Verbindungen zusammenwirft) C++-Template-Metaprogrammierung betreiben, Gedichte schreiben, Symphonien komponieren, Lieben, Hassen, Hoffen und sich sogar auf Blogs über irgendwas auslassen könnten. 😉

Und wie sollte man bei denen denn den Überblick behalten können, wenn man ihn schon bei dem kleinen hier gezeigten Beispiel verliert? Der entscheidende Punkt ist jedoch, dass das Ich/Bewusstsein kein Ding, sondern ein Vorgang ist.

Und wie sollte man bei denen denn den Überblick behalten können, wenn man ihn schon bei dem kleinen hier gezeigten Beispiel verliert? Der entscheidende Punkt ist jedoch, dass das Ich/Bewusstsein kein Ding, sondern ein Vorgang ist.

Da ein so emergentes System sehr nichtlinear ist, ist das Verhalten auch dementsprechend chaotisch (siehe von Wasserrädern, Kochtöpfen und Wettervorhersagen). Chaotisch bedeutet hier, dass man eben nicht einfach irgendwo durch einen gezielten Eingriff (einzelne Synapsen manipulieren) ein gewolltes Ergebnis auf der Emergenzebene darüber (Bewusstsein) erzeugen kann, ohne den ganzen Kram einfach komplett auszuprobieren. So wie das beim bereits verlinkten Game of Life eben auch der Fall ist.

Das Weiterzuführen folgender Gedankenspiele sei dem interessierten Leser ( 😛 ) überlassen:

1) Ist unser Bewusstsein tatsächlich auf die Informationen, die physikalisch innerhalb unseres Körpers hinterlegt sind, begrenzt, oder zählen externe Hilfsmittel zur Informationsverwaltung dazu, also Zettel, Smartphones, PCs, Internet, Freunde, Lebenspartner usw.? Das, was wir lernen, und wie wir unser Verhalten steuern ist ja schon teilweise ziemlich von soetwas abhängig und unter Umständen ist man bei überraschendem Fehlen dieser Zusätze ähnlich behindert, als wenn einem jemand ein kleines Stückchen Gehirn herausgeschnitten hätte.

2) Was für ein ethisches Verhalten würden wir jemandem gegenüber haben, dem man ein paar Neuronen und einige Synapsen durch künstliche (ob aus Spaß, oder weil’s wegen einer Krankheit/Verletzung nötig war) ersetzt hat, die genau gleich funktionieren, und der Mensch (incl. seinem epiphänomenalen? Bewusstsein) danach immernoch der gleiche ist? (Inwiefern das technisch/biologisch machbar ist, und ob auf Kohlenstoff- oder Silizium-Basis sei mal dahingestellt, ich hypothetisiere ja nur.) Und wenn man nun noch mehr austauscht? Und wenn man alles ausgetauscht hat? Und was wenn man direkt von Anfang an künstlich gebaut hätte? Wär’s irgendwie gemein, die Gefühle des einen Bewusstseins zu respektieren und die des anderen (genau so komplexen) vollständig zu ignorieren, nur weil die seinen gedanklichen Symbolen zugrundeliegende Hardware eine andere ist? 😉

Dieses Gedankenexperiment hatte ich auch im Buch „Artificial Intelligence: A Modern Approach“ gelesen. Genau betrachtet dürfte man hier eigentlich gar nicht unterscheiden. Bei dem einen wäre das Bewusstsein ein biologisch emergentes Phänomen und beim anderen ein „künstliches“, doch im Endeffekt gibt es keine Unterschiede im Resultat.

Um zu zeigen wie jegliche Gedankenprozesse von statten gehen ist, wie du schon aufgezeigt hast, mit heutigen Methoden schlicht nicht möglich. Ich würde als Beweis eher eine Kopie eines Gehirns erstellen und es dann versuchen zu simulieren, z.B. durch das Ersetzen aller einzelner Synapsen, Neuronen und was es noch so zu ersetzen gibt, mit künstlichen Duplikaten, dessen Aktivitäten und Verbindungen man dann mitloggen kann. 😛

Ein Gehirn, das nebenher terabyteweise Log-Dateien schreibt, wär echt mal cool. 😀

Nur ob man da dann irgendwas nützlich rauslesen kann, ist halt fraglich. 😉

Nur aus Neugierde:

Hast du zur Erschließung einiger der Grundlagen für diesen Artikel zufällig folgendes Werk benutzt? http://tinyurl.com/7nq6jvk

Einige deiner Formulierungen in den ersten Absätzen habe ich dort schonmal ziemlich ähnlich gelesen. 🙂

Falls das nur Zufall ist oder einen komplexeren Zusammenhang hat (du es also noch nicht kennst) kann ich dir das Buch sehr empfehlen.

Haben die etwa einen Tag nachdem ich meinen Artikel online gestellt habe die Sachen schon übernommen und ein Buch draus gemacht? Nice. XD

Ja ne, das Buch kenn ich noch nich. Hab den kram eher aus Gunther Duecks Omnisophie, dem Artificial-Intelligence-Ding, das Stan schon erwähnt hatte, Wikipedia, vielleicht aus Robert Sapolskys Vorlesungen, und irgendwelchen Sachen, die man so ergoogelt. Werd aber gleich mal bei Amazon ’nen Blick in dein Buch da werfen. Vom Schreibstil her muss es ja wohl ziemlich cool sein, wenns meinem Blog hier ähnelt. 😉

Pingback: Naturalismus, Kontinua und Mitgefühl | dem Dobi sein Blog

Pingback: Aufgeschlossenheit | dem Dobi sein Blog

Hi, Ich schreibe zur zeit eine Seminarfacharbeit zum Thema „alkohol- und drogenbedingte Autounfälle“. Hierzu würde ich gerne das oben stehende

Da fehlt ein Verb. 😀 Ich vermute mal, du wolltest „verwenden“ schreiben. Klar, du darfst meine Texte gerne verwenden. Wäre halt cool wenn du irgendwo ’nen Vermerk auf die Herkunft hast. 🙂

Pingback: Zwei Systeme und nur ein Kopf | dem Dobi sein Blog

Pingback: Willensfreiheit | dem Dobi sein Blog

Pingback: Der Tod | dem Dobi sein Blog

Pingback: Dinge, die wir eventuell gar nicht verstehen können | dem Dobi sein Blog