Da wir eigentlich ja nur Linsensuppe in unseren Köpfen haben (siehe Neuronale Netze und das Leib-Seele-”Problem”), entspricht jede einfache Modellvorstellung über unsere mentalen Zustände natürlich nicht der biologischen Realität. Trotzdem finde ich manche Ansätze da recht nett, einfach um in der Praxis etwas zu haben, mit dem man forschen und sich im Alltag bewegen kann. Daniel Kahneman und Amos Tversky haben sich da etwas ganz nettes ausgedacht. Das Denken wird in zwei Systeme (1 und 2) unterteilt. Auch wenn es sich auf den ersten Blick vielleicht etwas wie das Freud’sche Es und Ich oder die bildhafte Funktionstrennung der zwei Gehirnhälften anhört, ist es doch anders.

Da wir eigentlich ja nur Linsensuppe in unseren Köpfen haben (siehe Neuronale Netze und das Leib-Seele-”Problem”), entspricht jede einfache Modellvorstellung über unsere mentalen Zustände natürlich nicht der biologischen Realität. Trotzdem finde ich manche Ansätze da recht nett, einfach um in der Praxis etwas zu haben, mit dem man forschen und sich im Alltag bewegen kann. Daniel Kahneman und Amos Tversky haben sich da etwas ganz nettes ausgedacht. Das Denken wird in zwei Systeme (1 und 2) unterteilt. Auch wenn es sich auf den ersten Blick vielleicht etwas wie das Freud’sche Es und Ich oder die bildhafte Funktionstrennung der zwei Gehirnhälften anhört, ist es doch anders.

- System 1 ist schnell, automatisch, intuitiv, implizit und unbewusst.

- System 2 ist langsam, abwägend, analytisch, bewusst und anstrengend.

Das meiste, was wir so tun oder entscheiden kommt von System 1. Es kann ganz tolle Dinge wahnsinnig schnell und sicher. Dinge, die man am Computer bisher so noch nicht in dieser Qualität und Effizienz implementieren konnte. Du brauchst dir nur kurz dieses Bild anschauen:

Auch ohne Sherlock Holmes zu sein, weißt du sofort, dass der Typ da das kleine Kind vermutlich sehr gerne mag, das Kind gerade von irgendwas abgelenkt ist, die Zunge rausstreckt usw. Über nichts davon musstest du nachdenken. Du wusstest es sofort. Dein System 1 hat Blickrichtungen, Gesichtsausdrücke usw. blitzschnell interpretiert und Schlüsse gezogen. Keine Software der Welt kann das so gut wie du.

Auch ohne Sherlock Holmes zu sein, weißt du sofort, dass der Typ da das kleine Kind vermutlich sehr gerne mag, das Kind gerade von irgendwas abgelenkt ist, die Zunge rausstreckt usw. Über nichts davon musstest du nachdenken. Du wusstest es sofort. Dein System 1 hat Blickrichtungen, Gesichtsausdrücke usw. blitzschnell interpretiert und Schlüsse gezogen. Keine Software der Welt kann das so gut wie du.

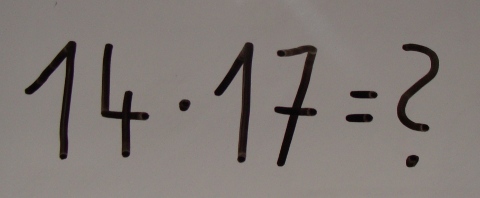

Hier nun was für System 2:

Wahrscheinlich hast du gar keine Lust, das jetzt auszurechnen, denn es ist anstrengend. Wenn du es doch machst, erweitern sich deine Pupillen messbar bis du fertig bist. (238 ist übrigens das Ergebnis, du Fauli. :P) Hierbei wäre selbst jeder uralte Taschenrechner wesentlich schneller und zuverlässiger als du.

Wahrscheinlich hast du gar keine Lust, das jetzt auszurechnen, denn es ist anstrengend. Wenn du es doch machst, erweitern sich deine Pupillen messbar bis du fertig bist. (238 ist übrigens das Ergebnis, du Fauli. :P) Hierbei wäre selbst jeder uralte Taschenrechner wesentlich schneller und zuverlässiger als du.

Wenn man übrigens den beiden Systemen einen MBTI zuordnen wollen würde, würde *NFP (zu 1) und *STJ (zu 2) vermutlich am ehesten passen.

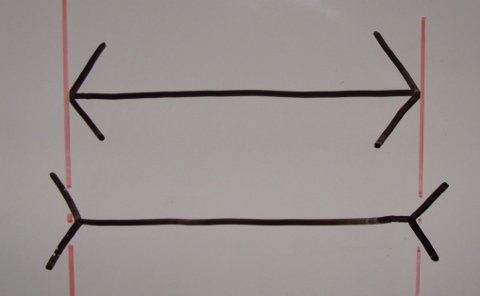

So, System 1 ist toll, 2 stinkt ab. Es gibt aber auch außer langweiligem Kopfrechnen noch andere Dinge, die System 1 nicht so gut kann. Unvoreingenommen und objektiv urteilen ist eins davon. Es gibt eine Menge Schwächen, die in bestimmten Situationen zum Tragen kommen. Das Gemeine daran ist, dass wir sie gar nicht wahrnehmen, weil System 2 im Normalfall einfach schluckt, was es von System 1 so vorgesetzt bekommt. Wir identifizieren uns zwar immer mit unserem System 2, sind aber in Wahrheit viel viel mehr unser uns selbst fast unbekanntes System 1. Optische Illusionen kennen wir alle ein paar, wie beispielsweise die Müller-Lyer-Illusion:

Man meint, die untere Linie sei auch wenn man die komischen Enden weglässt eindeutig länger als die obere, ist sie aber nicht:

Man meint, die untere Linie sei auch wenn man die komischen Enden weglässt eindeutig länger als die obere, ist sie aber nicht:

Wenn man diese Dinge kennt, fällt man nicht mehr drauf rein. Statt optischen Illusionen gibt es auch kognitive Illusionen (zum Teil auch Denkfallen genannt), in die unser System 1 kompromisslos reinlatscht, und das auch bei wichtigen Entscheidungen, die weitreichende Folgen für unser und das Leben anderer haben können. Deshalb denke ich, lohnt es sich, einige davon zu kennen. Das Ganze in der Hoffnung sie im richtigen Moment auch zu bemerken, und die Ergebnisse unter Benutzung von System 2 nochmal überdenken zu können. (Zumindest sollte man wissen, dass es sie gibt.)

Wenn man diese Dinge kennt, fällt man nicht mehr drauf rein. Statt optischen Illusionen gibt es auch kognitive Illusionen (zum Teil auch Denkfallen genannt), in die unser System 1 kompromisslos reinlatscht, und das auch bei wichtigen Entscheidungen, die weitreichende Folgen für unser und das Leben anderer haben können. Deshalb denke ich, lohnt es sich, einige davon zu kennen. Das Ganze in der Hoffnung sie im richtigen Moment auch zu bemerken, und die Ergebnisse unter Benutzung von System 2 nochmal überdenken zu können. (Zumindest sollte man wissen, dass es sie gibt.)

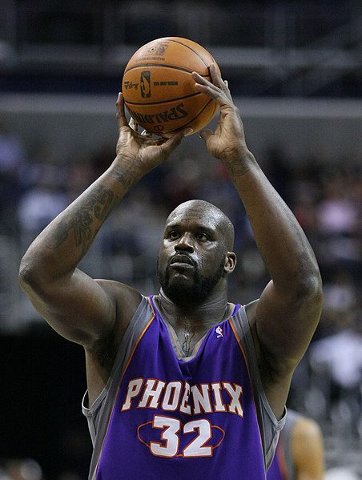

Fangen wir mit etwas (emotional) einfachem an: Sagen wir, ich trainiere eine Basketballmannschaft. Einer der Spieler schießt schlecht Freiwürfe, weswegen ich sie nach dem normalen Training nochmal extra mit ihm übe.

Von den ersten 10 Würfen trifft er 8 Stück. Das finde ich gut, und lobe ihn dafür. Von den nächsten 10 versemmelt er 7, worauf ich ihn tadel. Danach sind es wieder ein paar mehr, usw. Ohne Nachzudenken könnte ich das Gefühl bekommen, dass er durch Lob beim nächsten mal schlechter wird und durch Tadel besser. Also lasse ich das Loben doch lieber ganz sein. Freiwürfe haben aber nunmal zusätzlich zum Können auch etwas mit Glück zu tun, wodurch es ganz normal ist, dass man mal mehr und mal weniger trifft. Nach einem besonders guten oder schlechten Ausreißer ist es normal, dass wieder zur Mitte hin regressiert wird. Das muss gar nicht unbedingt etwas mit dem Kommentar des Trainers zu tun haben. Wenn man eine Studie mit mehreren Spielern macht, könnte sogar dabei herauskommen, dass Zuckerbrot im Schnitt wesentlich besser funktioniert als Peitsche, und die kurzfristig subjektiv entstandene Trainer-Intuition, der sich auf Grund dieser schon nur aufs Meckern versteift hat, genau falsch war. Soetwas kann natürlich auch in anderen Situationen vorkommen, in denen der Zufallsfaktor nicht so offensichtlich ist. Erkennt ein Personalmanager, dass die Leistungen seiner Mitarbeiter unter anderem auch ganz natürlichen Zufallsschwankungen (auch von Projekt zu Projekt) unterliegen, oder kommt er eher zu dem Schluss, dass die Leute Lorbeeren nur benutzen, um sich darauf auszuruhen? (Es könnte tatsächlich so sein, es könnte aber genau wie beim Freiwurftraining Quatsch sein.)

Von den ersten 10 Würfen trifft er 8 Stück. Das finde ich gut, und lobe ihn dafür. Von den nächsten 10 versemmelt er 7, worauf ich ihn tadel. Danach sind es wieder ein paar mehr, usw. Ohne Nachzudenken könnte ich das Gefühl bekommen, dass er durch Lob beim nächsten mal schlechter wird und durch Tadel besser. Also lasse ich das Loben doch lieber ganz sein. Freiwürfe haben aber nunmal zusätzlich zum Können auch etwas mit Glück zu tun, wodurch es ganz normal ist, dass man mal mehr und mal weniger trifft. Nach einem besonders guten oder schlechten Ausreißer ist es normal, dass wieder zur Mitte hin regressiert wird. Das muss gar nicht unbedingt etwas mit dem Kommentar des Trainers zu tun haben. Wenn man eine Studie mit mehreren Spielern macht, könnte sogar dabei herauskommen, dass Zuckerbrot im Schnitt wesentlich besser funktioniert als Peitsche, und die kurzfristig subjektiv entstandene Trainer-Intuition, der sich auf Grund dieser schon nur aufs Meckern versteift hat, genau falsch war. Soetwas kann natürlich auch in anderen Situationen vorkommen, in denen der Zufallsfaktor nicht so offensichtlich ist. Erkennt ein Personalmanager, dass die Leistungen seiner Mitarbeiter unter anderem auch ganz natürlichen Zufallsschwankungen (auch von Projekt zu Projekt) unterliegen, oder kommt er eher zu dem Schluss, dass die Leute Lorbeeren nur benutzen, um sich darauf auszuruhen? (Es könnte tatsächlich so sein, es könnte aber genau wie beim Freiwurftraining Quatsch sein.)

Auch wenn man gar nicht selbst interagiert (in dem Fall lobt oder tadelt) gibt es lustige Effekte. Wenn ein Skisprung-Event zwei Tage geht und ein Springer am ersten Tag besonders gut war und am zweiten nur noch mittelmäßig neigen Reporter gerne zu Aussagen wie „Nach der Spitzenleistung war der Erwartungsdruck einfach zu hoch.“. Wenn jemand, der am ersten Tag besonders schlecht war am zweiten Tag besser war, heißt es „Jetzt konnte er ganz gelöst springen, er hatte ja nichts mehr zu verlieren.“. Dabei ist es in beiden Fällen wieder nur ganz banale Regression zur Mitte gewesen. Aber System 1 ist sehr gut darin, in allem irgendwelche Kausalzusammenhänge zu sehen, auch wo keine sind. Dazu kommt, dass es meistens auch nur einen Grund ausspuckt, anstatt die Komplexität der Sache zu erfassen wenn tatsächlich sehr viele Faktoren zusammenkommen (Fallacy of the single cause). Und hinterher sagt man dann gerne „Hab ich doch gleich gesagt.“ (hindsight bias) selbst wenn man es gar nicht wirklich hatte. Die Erinnerung spielt einem da einfach einen Streich, denn sie ist manchmal nicht sehr stabil. Ja, wir erinnern uns an Dinge, die gar nicht so waren!

Das Self-serving bias ist eine Eigenschaft von System 1, die einen dazu bringt, eigenes Scheitern eher auf äußere Umstände zu schieben und Erfolg eher auf innere Werte/Fähigkeiten. Börsianer sind darin besonders gut. Der Markt ist ziemlich effizient (Was es über ein Wertpapier zu wissen gibt, ist schon im Preis mit drin.) und die Erträge der Spekulanten sind genauso verteilt wie wenn man seine Aktien einfach zufällig auswählen würde (siehe Don’t Blink! The Hazards of Confidence). Im Prinzip wird da mit sehr hohen Beträgen nichtmal Poker sondern eher Roulette gespielt, und die, die bisher Glück hatten, werden für angebliche Fähigkeiten bewundert. (Wenn jemand beim Mensch-ärgere-Dich-nicht-Spielen fünf mal hinter die sechs würfelt, würde einem doch auch kein „Boa, krass wie du’s drauf hast!“ entfleuchen. ;)). Aber dass die Börse chaotisch ist, will unser System 1 einfach nicht wahrhaben, und es wirft immer weiter mit Kausalerklärungen um sich. Beim Basketball macht man etwas ähnliches wenn man davon ausgeht, dass Spieler soetwas wie eine „heiße Hand“ haben wenn sie mehrmals hintereinander getroffen haben. Entgegen allgemeinem (Irr-)Glauben ist die Chance nach ein paar getroffenen Würfen wieder nicht daneben zu werfen statistisch nämlich nicht erhöht. Die Welt ergibt aber einfach viel weniger Sinn als wir denken. Ein großer Teil der Kohärenz entsteht erst (und nur) in unserem Kopf. 🙂

Das Self-serving bias ist eine Eigenschaft von System 1, die einen dazu bringt, eigenes Scheitern eher auf äußere Umstände zu schieben und Erfolg eher auf innere Werte/Fähigkeiten. Börsianer sind darin besonders gut. Der Markt ist ziemlich effizient (Was es über ein Wertpapier zu wissen gibt, ist schon im Preis mit drin.) und die Erträge der Spekulanten sind genauso verteilt wie wenn man seine Aktien einfach zufällig auswählen würde (siehe Don’t Blink! The Hazards of Confidence). Im Prinzip wird da mit sehr hohen Beträgen nichtmal Poker sondern eher Roulette gespielt, und die, die bisher Glück hatten, werden für angebliche Fähigkeiten bewundert. (Wenn jemand beim Mensch-ärgere-Dich-nicht-Spielen fünf mal hinter die sechs würfelt, würde einem doch auch kein „Boa, krass wie du’s drauf hast!“ entfleuchen. ;)). Aber dass die Börse chaotisch ist, will unser System 1 einfach nicht wahrhaben, und es wirft immer weiter mit Kausalerklärungen um sich. Beim Basketball macht man etwas ähnliches wenn man davon ausgeht, dass Spieler soetwas wie eine „heiße Hand“ haben wenn sie mehrmals hintereinander getroffen haben. Entgegen allgemeinem (Irr-)Glauben ist die Chance nach ein paar getroffenen Würfen wieder nicht daneben zu werfen statistisch nämlich nicht erhöht. Die Welt ergibt aber einfach viel weniger Sinn als wir denken. Ein großer Teil der Kohärenz entsteht erst (und nur) in unserem Kopf. 🙂

Dazu kommt, dass für solche Schlussfolgerungen von System 1 dann gerne auch nur noch die Tatsachen wahrgenommen werden, die sie bestätigen und die anderen ausgeblendet werden (confirmation bias). Beispielsweise wenn wir uns einbilden, dass eine Ampel immer rot wird wenn wir gerade mit dem Auto dahinkommen, oder dass unsere Supermarktkassenschlange immer die langsamste ist, machen wir das. System 1 hat es mit statistischem Denken (siehe Basketballtrainer/Personalchef) nicht so wirklich und produziert Erklärungen zwar wie irre, trifft die Wahrheit aber manchmal ähnlich präzise wie ein Besoffener beim Pinkeln das Klo. 😉

Wohin es trifft, kann dazu auch noch geprimed sein. Anchoring ist nur eins von vielen witzigen Beispielen dazu. Kognitions-Psychologen haben um das zu Testen Leute befragt, was die schätzen wieviel Prozent der Staaten in Afrika Mitglied der vereinten Nationen sind. Bevor die Leute diese Schätzung abgeben sollten, wurde ein Glücksrad mit Zahlen drauf gedreht, was so manipuliert war, dass es entweder bei den Zahlen 10 oder bei 65 stehen bliebt. Obwohl die Versuchsteilnehmen natürlich wussten, dass das Rad nichts mit der Frage zu tun hat, hat die 10er-Gruppe im Schnitt 25% geschätzt und die 65er-Gruppe 45%. Total banale Einflüsse können das Ergebnis also stark verändern. (Bei Verkaufsverhandlungen versuchen wir übrigens oft unser Gegenüber an irgendeine Zahl zu ankern.)

Wohin es trifft, kann dazu auch noch geprimed sein. Anchoring ist nur eins von vielen witzigen Beispielen dazu. Kognitions-Psychologen haben um das zu Testen Leute befragt, was die schätzen wieviel Prozent der Staaten in Afrika Mitglied der vereinten Nationen sind. Bevor die Leute diese Schätzung abgeben sollten, wurde ein Glücksrad mit Zahlen drauf gedreht, was so manipuliert war, dass es entweder bei den Zahlen 10 oder bei 65 stehen bliebt. Obwohl die Versuchsteilnehmen natürlich wussten, dass das Rad nichts mit der Frage zu tun hat, hat die 10er-Gruppe im Schnitt 25% geschätzt und die 65er-Gruppe 45%. Total banale Einflüsse können das Ergebnis also stark verändern. (Bei Verkaufsverhandlungen versuchen wir übrigens oft unser Gegenüber an irgendeine Zahl zu ankern.)

Aber auch Verhaltensentscheiden, die wir unseren innersten stabilsten Werten zuschreiben können sich durch Nichtigkeiten ändern. In einer Studie (vor der Zeit der Mobiltelefone) ließ ein Schauspieler vor einer Telefonzelle sein Zeug fallen, als der Benutzer eben dieser gerade heraus kam. Es wurde gemessen wie hoch der Anteil der Leute, die beim Aufheben geholfen haben, unter den Telefonierern war. Nur einer von 25 Leuten half. Wurde jedoch vorher ein 10-cent-Stück auf dem Telefon platziert, was die Testperson dann dort fand (und sich vermutlich drüber freute) wurde in 14 von 16 Fällen geholfen. (Do We Really Have Any Character Traits?)

Aber auch Verhaltensentscheiden, die wir unseren innersten stabilsten Werten zuschreiben können sich durch Nichtigkeiten ändern. In einer Studie (vor der Zeit der Mobiltelefone) ließ ein Schauspieler vor einer Telefonzelle sein Zeug fallen, als der Benutzer eben dieser gerade heraus kam. Es wurde gemessen wie hoch der Anteil der Leute, die beim Aufheben geholfen haben, unter den Telefonierern war. Nur einer von 25 Leuten half. Wurde jedoch vorher ein 10-cent-Stück auf dem Telefon platziert, was die Testperson dann dort fand (und sich vermutlich drüber freute) wurde in 14 von 16 Fällen geholfen. (Do We Really Have Any Character Traits?)

Zumindest bei einem für einen selbst unschönen Ergebnis schützt das Self-serving bias ist einen ja noch ein Bischen, aber wenn es um das Beurteilen des Verhaltens andere Leute geht, machen wir den Fundamental attribution error häufig. Wer intuitiv verstanden hat, dass die echten Erklärungen oft weniger intern, stabil und global und dafür mehr extern, instabil und lokal sind (siehe Explanatory style), hat schon einen großen Vorteil, weil er nicht nur über andere weniger schnell urteilt sondern auch selbst weniger depressionsgefährdet ist. Es scheint übrigens so zu sein, dass dieser Fehler in westlichen Kulturen öfter begangen wird als in asiatischen. Vielleicht liegt das ja ab der hier verbreiteten albernen Vorstellung von Gut und Böse.

Zumindest bei einem für einen selbst unschönen Ergebnis schützt das Self-serving bias ist einen ja noch ein Bischen, aber wenn es um das Beurteilen des Verhaltens andere Leute geht, machen wir den Fundamental attribution error häufig. Wer intuitiv verstanden hat, dass die echten Erklärungen oft weniger intern, stabil und global und dafür mehr extern, instabil und lokal sind (siehe Explanatory style), hat schon einen großen Vorteil, weil er nicht nur über andere weniger schnell urteilt sondern auch selbst weniger depressionsgefährdet ist. Es scheint übrigens so zu sein, dass dieser Fehler in westlichen Kulturen öfter begangen wird als in asiatischen. Vielleicht liegt das ja ab der hier verbreiteten albernen Vorstellung von Gut und Böse.

Ein weitere Eigenschaft von System 1, die es zu kennen lohnt, ist die, dass es schwer zu beantwortende Fragen intern gerne durch leichter zu beantwortende ersetzt werden, und die Antwort zu diesen dann als angebliche Antwort auf die eigentlichen Fragen präsentiert werden (Attribute substitution). Wenn wir beispielsweise nach zwei Vorstellungsgesprächen beurteilen wollen, welcher der beiden Ingenieure, die sich beworben haben, wohl der bessere System-Entwickler ist, was schwer zu entscheiden ist. Aber hey, wir wissen doch, welchen von beiden wir netter finden, also tun wir doch einfach so, als wär‘ der besser. (Hier kommt die substitution mit dem zusammen Halo-Effekt.)

Ein weitere Eigenschaft von System 1, die es zu kennen lohnt, ist die, dass es schwer zu beantwortende Fragen intern gerne durch leichter zu beantwortende ersetzt werden, und die Antwort zu diesen dann als angebliche Antwort auf die eigentlichen Fragen präsentiert werden (Attribute substitution). Wenn wir beispielsweise nach zwei Vorstellungsgesprächen beurteilen wollen, welcher der beiden Ingenieure, die sich beworben haben, wohl der bessere System-Entwickler ist, was schwer zu entscheiden ist. Aber hey, wir wissen doch, welchen von beiden wir netter finden, also tun wir doch einfach so, als wär‘ der besser. (Hier kommt die substitution mit dem zusammen Halo-Effekt.)

Das Availability Bias ist eine weitere nette Heuristik, die System 1 gerne anwendet, besonders wenn wir Risiken einschätzen wollen. Der Wahrscheinlichkeit an einer Krankheit oder durch einen Autounfall zu sterben ist weeeesentlich höher als die, durch einen Flugzeugabsturz oder einen Terroranschlag ums Leben zu kommen. Trotzdem sind die beiden letztgenannten Szenarien in den Medien wesentlich präsenter, was dazu führt, dass diese Gefahren extrem überbewertet werden. Das Problem ist, dass System 1 sehr schlecht aus Statistiken lernt und wesentlich mehr aus anschaulichen Einzelfällen, auch wenn diese eigentlich irrelevant sind. Wenn du mit deinem letzten Fernseher der Firma Blony „nichts als Probleme“ hattest, würde eine Statistik, die eindeutig zeigt, dass Geräte dieser Marke am zuverlässigstens sind, dich dazu bringen, dass dein nächster wieder ein Blony ist?

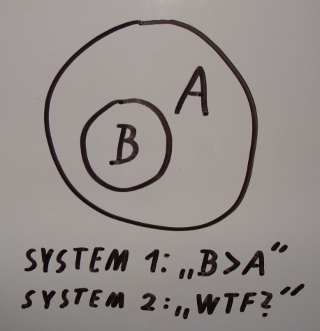

Als weiteres und (endlich ;)) letztes Highlight der System-1-Spezialitäten hätte ich nun noch die Conjunction fallacy zu bieten. Meine Version vom Linda-Problem sieht wie folgt aus:

Es gibt einen Tobias (über den du bisher noch gar nichts weißt), der als Schüler und Student immer sehr gerne viel Sport gemacht hat und mehr trainiert als gelernt hat. Nun ist er 30 Jahre alt. Welche dieser beiden Aussagen über Tobias hälst du für wahrscheinlicher:

- A) Tobias arbeitet als Software-Entwickler.

- B) Tobias arbeitet als Sofware-Entwickler und hängt mehrmals die Woche in Sporthallen rum und tobt sich dort aus.

Wenn du jetzt B sagst, hast du den gleichen Fehler gemacht, wie die Mehrzahl der Leute in der Originalstudie. SW-Entwickler, die in Sporthallen rumgammeln sind eine Untermenge aller Software-Entwickler. Aussage B kann also nicht wahrscheinlicher sein als A, was man an folgendem Euler-Diagramm gut sieht:

System 1 ist nicht nur manchmal schlecht in Statistik sondern auch im Beurteilen von Wahrscheinlichkeiten und im Anwenden von einfachster Logik. Entscheidender ist, wie schön passend sich die Geschichte anhört (cognitive ease).

System 1 ist nicht nur manchmal schlecht in Statistik sondern auch im Beurteilen von Wahrscheinlichkeiten und im Anwenden von einfachster Logik. Entscheidender ist, wie schön passend sich die Geschichte anhört (cognitive ease).

Malcom Gladwell sagt uns zwar, dass wir uns auf unsere erste Eingebung verlassen sollen, was auch oft richtig ist. Ich sage jedoch, dass wir sie zwar nutzen sollen (was ich als INTJ sowieso oft tue), es aber auch gut ist, zu wissen, dass man in nicht wenigen Situationen besser dran ist, wenn man sein System 2 benutzt, um seine Intuition aus System 1 kritisch zu hinterfragen. 🙂 Vielleicht kann man System 1 ja auch bewusst etwas darauf hintrainieren, noch bessere Intuitionen zu entwickeln, denn gerade wenn System 2 schon mit etwas anderem beschäftigt ist, will man ja nicht ungesichert ausgeliefert sein. 😉

Das Schalten beim Autofahren musste man in der Fahrschule ja auch noch bewusst machen und nun geht es wie von selbst. Und wieso sollte das nur mit Koordinationskram funktionieren? 🙂

Wenn du jetzt Spaß an sowas gefunden hast und gerne noch mehr solcher Voreingenommenheiten und Fallen kennenlernen willst, schau doch einfach mal bei Wikipedia rein: http://en.wikipedia.org/wiki/List_of_fallacies, http://en.wikipedia.org/wiki/List_of_cognitive_biases

Achja, die Prospect Theory (incl. Loss aversion, Endowment-Effekt, Mental accounting, usw.) finde ich ebenfalls recht amüsant, weil sie zeigt, inwiefern das das klassische rationale Verhaltensmodell der Wirtschaftswissenschaft nicht hinhaut. Aber drüber hier zu schreiben würde den Rahmen sprengen, also sieh und lies selbst. 😉

Nachtrag (27.11.2012): Es scheint so, dass einige der kognitiven Verzerrungen stark reduziert werden, wenn man über die Fragen, bei denen sie auftreten, in einer Fremdsprache (die man gut beherrscht) nachdenkt. Koreaner entscheiden beispielsweise rationaler bei Problemen, die in Englisch formuliert sind, Engländer bei Französischen vorgetragenen Fragen. Hier gibt es noch einiges zu erforschen mit eventuell interessanten Implikationen, die wir vielleicht sogar in unseren Alltag einfließen lassen könnten. 🙂

Pingback: Dooooooooooooooooooof. | dem Dobi sein Blog

Pingback: Talent oder Training, Nature or Nurture, Veranlagung oder Umwelteinflüsse? | dem Dobi sein Blog

Pingback: Dinge, die wir eventuell gar nicht verstehen können | dem Dobi sein Blog